GH200 발표

Nvidia는 최근 GH200 슈퍼 칩의 출시를 발표했습니다. 이 칩은 "가장 복잡한 생성 AI 작업, 대규모 언어 모델, 추천 시스템 및 벡터 데이터베이스를 포함"할 수 있다고 합니다. GH200은 현재 Nvidia의 가장 강력하고 인기 있는 AI 제품인 H100과 동일한 GPU를 갖지만 메모리 용량이 3배 늘어납니다. GH200 양산이 2024년 2분기에 시작될 것이라고 밝혔습니다.

Nvidia는 이미 AI 칩 시장에서 80% 이상의 점유율을 차지하고 있습니다.

그럼에도 Nvidia는 AMD, Google 및 Amazon과 같은 AI 하드웨어 분야의 경쟁자들을 물리치기 위해 새로운 AI 칩인 GH200을 선보였습니다.

AMD는 올해 4분기에 자체 AI GPU 생산을 늘리려고 합니다. 그러나 Nvidia는 생성 AI GPU에서 거의 독점적입니다.

성능 측면에서 DGX GH200은 놀라운 성능과 전력 사양을 가지고 있습니다. GPU 메모리가 훨씬 더 크며, GPU 수가 더 많기 때문입니다. DGX GH200은 광범위한 사용을 위해 만들어졌으며, AI 훈련 모델과 데이터 분석에 엄청난 확장성을 가져다줍니다.

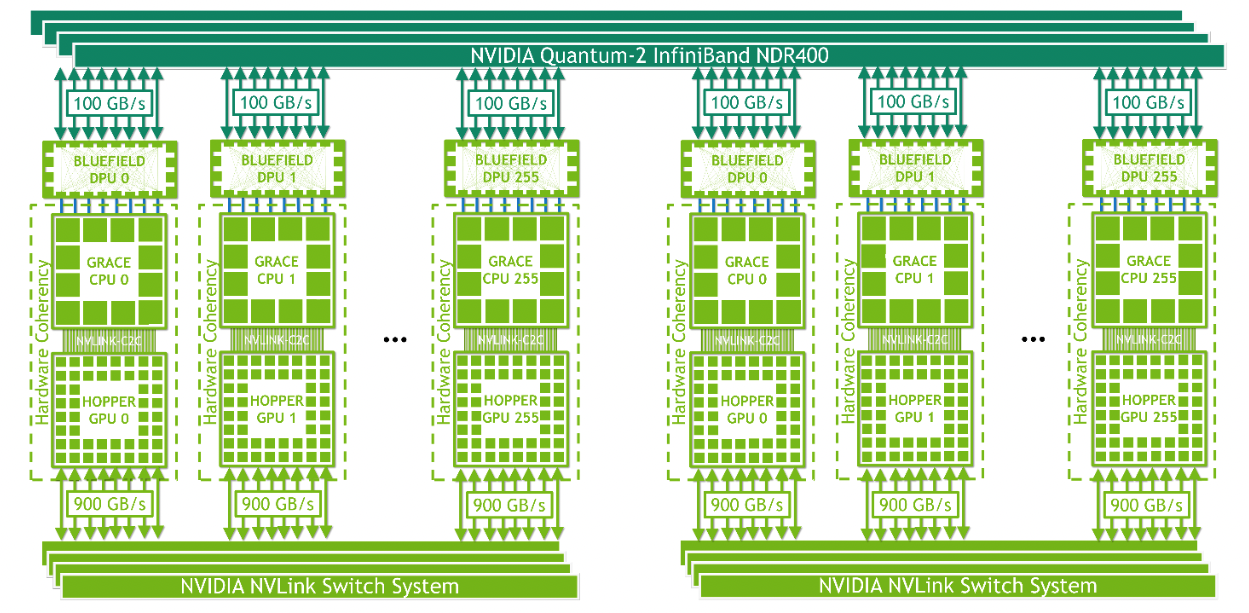

NVIDIA의 차세대 AI칩인 GH200은 새로운 클래스의 AI 슈퍼컴퓨터로, 256개의 NVIDIA Grace Hopper 슈퍼칩을 단일 GPU에 완전히 연결합니다. NVIDIA DGX GH200은 대규모 추천 시스템, 생성형 AI 및 그래프 분석을 위한 테라바이트급 모델을 처리하도록 설계되었으며, 거대한 AI 모델을 위한 선형 확장성과 함께 144테라바이트 (TB)의 공유 메모리를 제공합니다.

NVIDIA DGX GH200은 256개의 NVIDIA Grace Hopper 슈퍼칩에 걸쳐 144TB의 대용량 공유 메모리 공간을 제공하는 유일한 AI 슈퍼컴퓨터로, 개발자에게 500배 이상의 메모리를 제공하여 거대한 모델을 구축할 수 있도록 지원합니다. Grace Hopper 슈퍼칩은 동일한 회로 기판에서 NVIDIA Grace CPU와 NVIDIA Hopper GPU를 결합하여 대역폭을 7배 증가시키고 상호 연결 전력 소비를 5배 이상 줄임으로써 기존의 PCIe CPU-GPU 연결이 필요하지 않습니다.

턴키 DGX GH200 배포를 통해 몇 달이 아닌 몇 주 만에 대규모 모델을 구축할 수 있습니다. 이 풀스택 데이터센터급 솔루션에는 설계부터 배포까지 NVIDIA의 통합 소프트웨어 및 화이트 글러브 서비스가 포함되어 있어 AI의 ROI를 빠르게 실현할 수 있습니다. DGX GH200은 NVLink 스위치 시스템으로 모든 Grace Hopper 슈퍼칩 간에 NVIDIA NVLink를 확장하여 256개의 GPU로 확장할 수 있습니다.

Grace Hopper 슈퍼칩

NVIDIA Grace Hopper 슈퍼칩은 대규모 AI 및 HPC 애플리케이션을 위한 획기적인 가속 CPU입니다. 이 슈퍼칩은 NVIDIA® NVLink-C2C를 사용하여 Grace 및 Hopper 아키텍처를 결합하여 가속화된 AI 및 HPC 애플리케이션을 위한 CPU+GPU 코히어런트 메모리 모델을 제공합니다. 이 슈퍼칩은 테라바이트의 데이터를 실행하는 애플리케이션에 최대 10배 더 높은 성능을 제공하여 과학자와 연구원이 세계에서 가장 복잡한 문제에 대한 전례 없는 솔루션에 도달할 수 있도록 합니다.

NVIDIA GH200 Grace Hopper Superchip은 PCIe Gen5보다 7배 빠른 새로운 초당 900GB/s (초당 기가바이트) 코히어런트 인터페이스를 제공하며, NVIDIA DGX A100 대비 GPU에 대한 총 시스템 메모리 대역폭이 30배 증가합니다. 이 슈퍼칩은 NVIDIA RTX, NVIDIA HPC, NVIDIA AI 및 Omniverse를 포함한 NVIDIA의 모든 컴퓨팅 소프트웨어 스택을 실행합니다.

차이점

NVIDIA의 GH200은 다른 AI 칩과 비교하여 매우 강력한 성능을 제공합니다. GH200은 NVIDIA의 현재 세대의 가장 강력한 AI 전용 칩인 H100의 후속 제품으로, 동일한 GPU를 사용하지만 메모리 용량이 141GB로 증가합니다. 이는 GH200이 H100보다 메모리 용량이 3배 더 많다는 것을 의미합니다. GH200은 "가장 복잡한 생성형 AI 작업, 대규모 언어 모델, 추천 시스템 및 벡터 데이터베이스"를 처리할 수 있다고 NVIDIA가 말합니다.

NVIDIA DGX GH200과 DGX H100을 비교하면, DGX GH200은 GPU 메모리가 훨씬 더 크며, 이는 GPU의 수가 더 많기 때문입니다. DGX GH200은 256개의 NVIDIA Grace Hopper Superchip을 사용하고, DGX H100은 8개의 NVIDIA H100 Tensor Core GPU를 사용합니다. 이러한 차이로 인해 DGX GH200은 놀라운 성능과 전력 사양을 가지고 있습니다.

NVIDIA 외에도 AMD와 같은 다른 회사들도 자체 AI GPU를 생산하기 위해 노력하고 있습니다. 하지만 NVIDIA는 생성형 AI에 적합한 GPU에서 거의 독점적인 위치를 차지하고 있습니다. AWS, Azure 및 Google과 같은 클라우드 제공 업체들은 모두 NVIDIA의 H100 Tensor Core GPU를 사용하고 있으며, 대규모 언어 모델을 사용하여 프로젝트를 시작하는 클라이언트들에게 서비스를 제공하는 것으로 차별화되어 있습니다.

Nvidia는 GH200의 가격을 공개하지 않았습니다. 현재 H100 라인은 대략 $40,000에 판매되고 있습니다.

'컴퓨터' 카테고리의 다른 글

| 엔비디아, 모든 RTX 시리즈에 적용되는 DLSS 3.5 업데이트 (31) | 2023.09.10 |

|---|---|

| 삼성과 SK하이닉스가 점유율 90%인 HBM 시장 (371) | 2023.08.11 |

| 차세대 반도체라 불리는 GaN 반도체와 실리콘 카바이드 반도체 (0) | 2023.08.07 |

| 삼성도 열심히 연구 중인 차세대 반도체, PIM과 LLW DRAM (0) | 2023.08.03 |

| 맥북에서 한글 파일 작업은 한컴독스가 가장 편하다. (0) | 2023.07.25 |